Beiträge von Syntafin

-

-

Ich bin es geohnt bei Installern jeglicher Art immer auf Weiter, Weiter, Weiter zu klicken, beziehungsweise Enter zu spammen. Und bei Chip muss man bei der Abfrage Wollen Sie Opera GX installieren immer auf Abbrevchen drücken nicht auf weiter. Und welche Quelle empfilst du für Sachen wenn nicht Chip?

Die Quelle, nicht den Virenverteiler.

Aber hey, Pacman regelt, für Windows heißt das glaube Winget.

-

Opera ist so ein Spam. Es installiert sich dauernt versehntlich über solche sus programme wie Chip Installer. ich hatte schon so viele komische versionen von opera auf meiner festplatte und möchte mit so einem aufdringlichen unternehmen nicht zu tun haben.

Da bist du aber selbst schuld, da du Chip vereendest. Zudem, dürfte die Option abschaltbar sein, da es sonst ja untergejubelt wäre.

-

Nein, ich nutze keine Spyware von Tencent

-

Wie das?

Ich zahle über Argentinien 1,80 für Family und über Türkei 2,30Argentinien, du gehst doch hoffentlich nicht über PayPal?

-

Ich zahle 1€ für YouTube Premium Family. Selber Trick.

-

hmm, ich muss leider zugeben, dass sowas manchmal sehr praktrisch ist. und immerhin verändert es nicht die syntax wie dein laverel

Hierzu sei Mal gesagt, das Laravel keinen Syntax ändert. Du verstehst hier nur den Unterschied zwischen HTML und einem Template nicht.

Wollte ich dir ja Mal zeigen, aber du scheinst nie Zeit für zu haben

-

Ignorieren

-

Xmpp bzw. die abgewandelte Version z.B. bei WhatsApp läuft zentral. Matrix bietet die gleichen Funktionen nur dezentral an.

Das ist so nicht korrekt, propitäre Angebote wie WhatsApp (rechtlich übrigens nicht verwendbar ohne sich strafbar zu machen) sind die einzigen die unter "läuft zentral" fallen.

XMPP ist und war schon immer dezentral, auch so Dinge wie Bridges gibt es dort seit Anbeginn der Zeit.

-

Wenn man ihn versteht.. mir persnlich hilft es für das verständnis es selber programmiert zu haben

Dazu möchte ich mal sagen, das es natürlich gut ist wenn man selbst weiß wie etwas funktioniert, es kommt aber die Zeit, da will man sich mit den ständigen Boilerplate arbeiten nicht mehr ärgern und vor allem auf das wesentliche konzentrieren.

Genau da greifen Frameworks wie Laravel, Symfony, CodeIgniter oder sogar WCF.

Aber gerade bei Mammut Aufgaben wie zB ein PSR-7 fähiger HTTP Client, muss man sich wahrlich nicht selbst antun, denn Guzzle liefert es fertig, ist verbreitet, aktiv gepflegt und der Quellcode ist öffentlich.

Mal als Beispiel, hier ein Vergleich wie die selbe Aufgabe aussieht, wenn du den cURL Client händisch konfigurierst oder Guzzle verwendest:

PHP: curl.php

Alles anzeigen<?php $url = 'https://discord.com/api/v10/guilds/{SERVER_ID}/channels'; $token = 'YOUR_DISCORD_TOKEN'; $ch = curl_init($url); curl_setopt($ch, CURLOPT_HTTPHEADER, [ 'Authorization: Bot ' . $token, 'Content-Type: application/json' ]); curl_setopt($ch, CURLOPT_RETURNTRANSFER, true); $response = curl_exec($ch); curl_close($ch); if ($response) { $data = json_decode($response, true); // Verarbeite die erhaltenen Daten var_dump($data); } else { echo 'Fehler beim Abrufen der Daten.'; }PHP: guzzle.php

Alles anzeigen<?php require 'vendor/autoload.php'; use GuzzleHttp\Client; $url = 'https://discord.com/api/v10/guilds/{SERVER_ID}/channels'; $token = 'YOUR_DISCORD_TOKEN'; $client = new Client(); try { $response = $client->request('GET', $url, [ 'headers' => [ 'Authorization' => 'Bot ' . $token, 'Content-Type' => 'application/json' ] ]); $data = json_decode($response->getBody(), true); // Verarbeite die erhaltenen Daten var_dump($data); } catch (GuzzleHttp\Exception\RequestException $e) { echo 'Fehler beim Abrufen der Daten: ' . $e->getMessage(); } -

schade. Wie meinst du das mit dem API key?

Wie stellst du dir das sonst mit den Kosten bitte vor? Ich trage bestimmt nicht die Kosten für andere.

-

Spotify kostet kein geld un youtube auch nicht. es gibt nur bei beiden die premium versionen aber die brauch man nicht unbeding.

Spotify bietet free nur mickrige Qualität und haut Werbung rein, genau wie YouTube. So werden die finanziert.

-

und ich krieg eine kostenlosen account?

Nein, eventuell kommt aber die Möglichkeit einen eigenen API Key anzugeben. Kommt jetzt erstmal drauf an wie das mit Kleingewerbe abläuft.

-

Natürlich kostet das Geld? Wer geht schon arbeiten ohne Geld zu wollen dafür?

-

ich hab leider keine möglicheit gefunden massenhaft songs von spotify runterzuladen. Nur indem ich das lied abspiele und währenddessen das audio aufzeichne, aber das kann man höchstens für einen song machen. und andere quellen für gute lieder kenne ich.

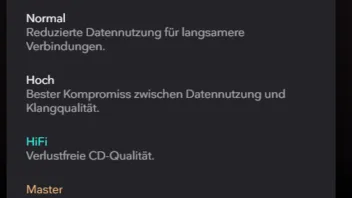

TIDAL

nichts schlägt die Qualität davon.

nichts schlägt die Qualität davon.Spotify's "Sehr hoch" ist "Normal" bei TIDAL und das kommende HiFi Upgrade bei Spotify ist "Hoch"

-

wow, wann gehts online?

Wenn fertig (ist es fast) und Kleingewerbe angemeldet ist.

-

ahh und dann kann ich den programmordner jemanden schicken und der brauch kein node.js um die app zu starten?

Nein du schickst ihm den Installer

Lalalalala

-

YouTube hat mir eine zu schlechte Qualität... wir sollten übrigens damit ins Smalltalk Thema

-

Weiß Jemand wie ich meine electron App so exportieren kann, dass der empfänger kein node.js und so ein zeug installiert haben muss? discord läuft ja auch ohne dass ich dafür extra node.js installiert habe. das muss irgendwie gehen nur wie?

Compilieren, meist via npm run build

-

Ups sorry hab ich gar nicht gemerkt. aber spieleentwickler sag ich sowiso zu allen.

In welcher Brancher arbeitetst du noch gleich? webentwickler?

Kunststoff

respekt. da ist meine 50gb Mp3 Musiksammlung ja nichts gegen